机器之心报道

编辑:小舟

Stable Diffusion 模型无需预处理和后处理,几秒钟内就能创造出令人惊叹的艺术图像。

根据文本生成图像是近来大火的一个研究方向。无论是英伟达的 GauGAN,还是 OpenAI 的 DALL·E,都获得了令人印象深刻的结果。但这些模型都是参数量过亿的超大模型,普通的消费级 GPU 根本无法支持。

现在,来自慕尼黑大学和 Runway 的研究者基于其 CVPR 2022 的论文《High-Resolution Image Synthesis with Latent Diffusion Models》,并与 Eleuther AI、LAION 等团队合作,共同开发了一种可在消费级 GPU 上运行的文本转图像模型 Stable Diffusion,目前项目代码已开源。

代码地址:https://github.com/CompVis/stable-diffusion

Stable Diffusion 模型是首个在 4000 个 A100 Ezra-1 AI 超大集群上进行训练的文本转图像模型。在测试方面,研究团队已经和 10000 多名 beta 测试用户一起大规模测试该模型,每天可创建 170 万张图像。该研究后续还将发布该模型输出的开放合成数据集。

Stable Diffusion 可以在消费级 GPU 上的 10 GB VRAM 下运行,并在几秒钟内生成 512x512 像素的图像,无需预处理和后处理,这是速度和质量上的突破。

有网友使用 Stable Diffusion 模型的 beta 试用版模拟了世界的发展过程,效果非常震撼。

包括宇宙的演变:

生物的进化:

人类文明的发展:

论文方法

论文地址:https://arxiv.org/pdf/2112.10752.pdf

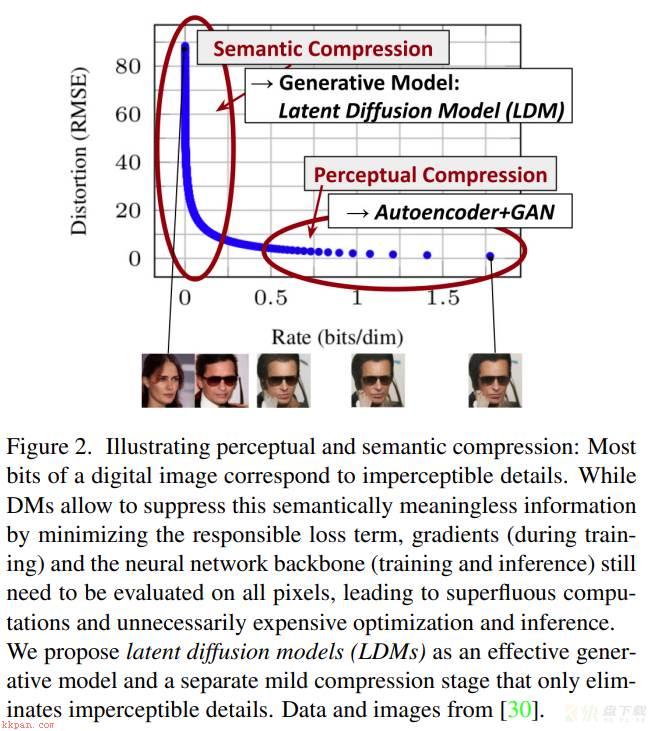

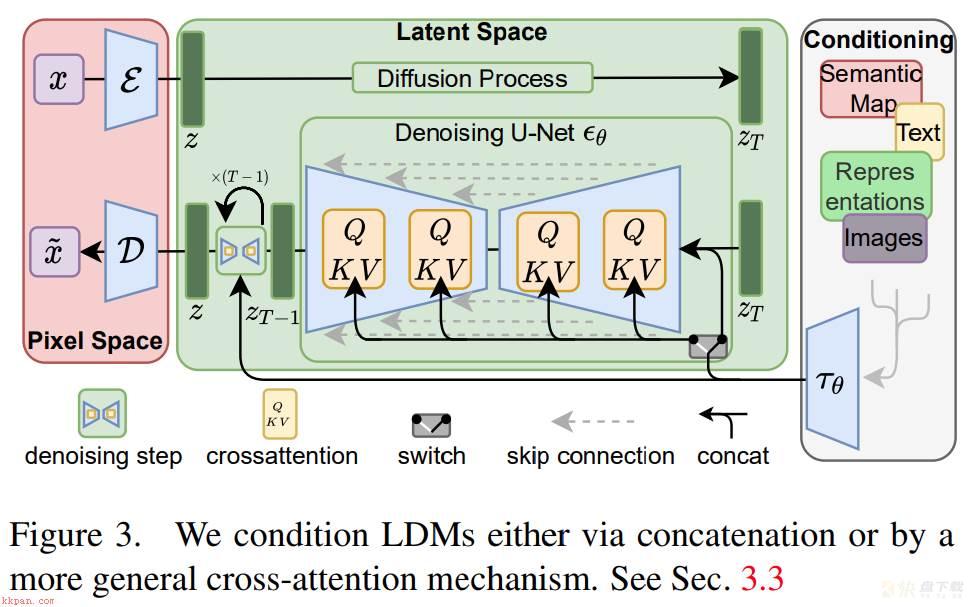

该研究试图利用扩散模型实现文字转图像。尽管扩散模型允许通过对相应的损失项进行欠采样(undersampling)来忽略感知上不相关的细节,但它们仍然需要在像素空间中进行昂贵的函数评估,这会导致对计算时间和能源资源的巨大需求。该研究通过将压缩与生成学习阶段显式分离来规避这个问题,最终降低了训练扩散模型对高分辨率图像合成的计算需求。

该研究使用一个自动编码模型学习一种空间,该空间在感知上与图像空间等效,却能显著降低计算复杂度。

这种方法提供了几个优点:

通过离开高维图像空间获得计算效率更高的 DM,因为采样是在低维空间上执行的;利用从其 UNet 架构继承的 DM 的归纳偏置,使得模型对具有空间结构的数据特别有效,减轻了先前方法对所需压缩级别的要求;获得了通用压缩模型,其潜在空间可用于训练多个生成模型,也可用于其他下游应用,例如单图像 CLIP 引导合成。感兴趣的读者可以阅读论文原文,了解更多研究细节。

「WAIC 2022 · AI 开发者日」重磅登场

2021 图灵奖得主、中外院士领衔 40+ 重磅嘉宾,开发者论坛、技术 Workshop、云帆奖、黑客马拉松 4 大精彩版块…… 9 月 3 日,「WAIC 2022 · AI 开发者日」将重磅登场, 以「 AI 开发者所真正关注的」为主题,集中展示本年度人工智能领域最前沿技术成果和最新实践应用进展,为开发者呈现一场集学习、实战、社交为一体的技术嘉年华。

AI 开发者论坛观众报名已经开启,扫描下图二维码即刻报名。