机器准备

系统初始配置

添加国内镜像源

软件安装、配置

使用kubeadm部署kubernetes

安装flannel网络

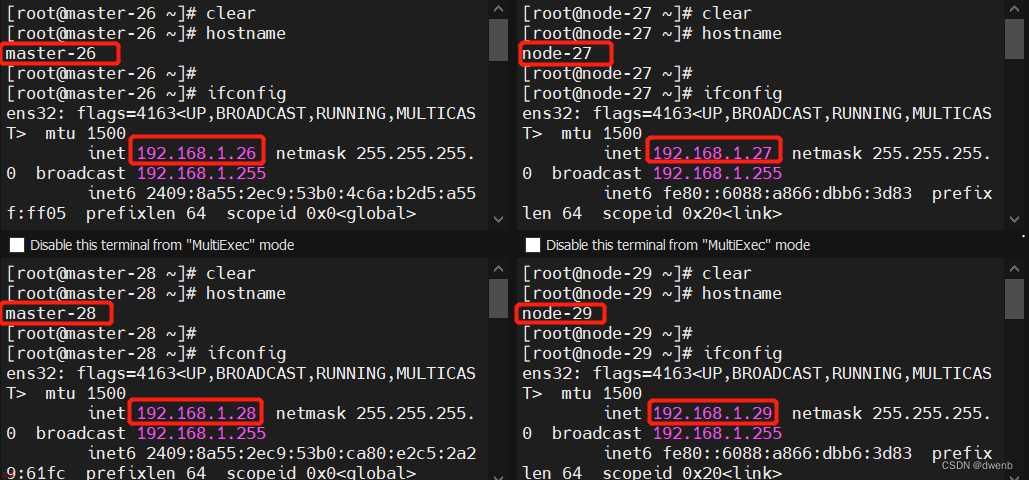

一、机器准备

本次试验准备的机器如下,需要注意的是k8s 要求 CPU 最低为 2 核,否则部署过程过程中会报错,虽然可以使用"–ignore-preflight-errors=…"参数忽视,但是这里不建议使用低于2CPU的配置部署k8s

二、系统初始配置

1、关闭swap:

kubernetes的想法是将实例紧密包装到尽可能接近100%。 所有的部署应该与CPU /内存限制固定在一起。 所以如果调度程序发送一个pod到一台机器,它不应该使用交换。 设计者不想交换,因为它会减慢速度,所以关闭swap主要是为了性能考虑,当然为了一些节省资源的场景,比如运行容器数量较多,可添加kubelet参数 --fail-swap-on=false来解决。

swapoff -a

sed-ri's/.*swap.*/#&/'/etc/fstab

2、关闭所有防火墙

systemctl stop firewalld

systemctl disable firewalld

3、禁用SELINUX

setenforce 0

sed-i's/SELINUX=enforcing/SELINUX=disabled/g'/etc/selinux/config

4、将桥接的IPv4流量传递到iptables的链

cat>/etc/sysctl.d/k8s.conf<<EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system

5、kube-proxy开启ipvs的前置配置

cat>/etc/sysconfig/modules/ipvs.modules<<EOF

#!/bin/bash

modprobe -- ip_vs

modprobe -- ip_vs_rr

modprobe -- ip_vs_wrr

modprobe -- ip_vs_sh

modprobe -- nf_conntrack_ipv4

EOF

chmod 755 /etc/sysconfig/modules/ipvs.modules && bash /etc/sysconfig/modules/ipvs.modules && lsmod|grep-e ip_vs -e nf_conntrack_ipv4

三、添加国内镜像源

1、添加centos8镜像源

curl http://mirrors.aliyun.com/repo/Centos-8.repo>/etc/yum.repos.d/Centos-8.repo

2、添加k8s源

cat <<EOF > /etc/yum.repos.d/kubernetes.repo[kubernetes]name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

3、添加ocker-ce源

curl https://mirrors.ustc.edu.cn/docker-ce/linux/centos/docker-ce.repo > /etc/yum.repos.d/docker-ce.repo

sed -i 's+download.docker.com+mirrors.tuna.tsinghua.edu.cn/docker-ce+' /etc/yum.repos.d/docker-ce.repo

四、软件安装、配置

1、升级containerd

cd /opt

wget https://download.docker.com/linux/centos/7/x86_64/edge/Packages/containerd.io-1.2.6-3.3.el7.x86_64.rpm

yum localinstall containerd.io-1.2.6-3.3.el7.x86_64.rpm

1、软件安装(其中keepalived、haproxy的安装配置只需要在三台master节点上操作)

yum install keepalived haproxy -y

yum install ipset ipvsadm -y

yum install yum-utils device-mapper-persistent-data lvm2 -y

yum install container-selinux -y

yum install docker-ce -y

yum install kubelet kubeadm kubectl -y

2、配置keepalived(三台master节点操作)

1)配置keepalived

vim /etc/keepalived/keepalived.conf

清空内容后将如下内容填写到配置文件

! Configuration File for keepalived

global_defs {

notification_email {

root@localhost

}

notification_email_from root@k8s.com

smtp_server 127.0.0.1

smtp_connect_timeout 30

router_id keepalived_lvs1

}

vrrp_instance VI_1 {

state MASTER

interface ens35

virtual_router_id 55

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass Kubernetes

}

virtual_ipaddress {

10.255.253.88

}

}

注意:

修改interface ens35中的ens35改为服务模块节点实际的网卡名

Master01、Master02、Master03三个节点的router_id分别改为router_id keepalived_lvs1、router_id keepalived_lvs2、router_id keepalived_lvs3

Master01、Master02、Master03三个节点中的state分别修改为state MASTER、state BACKUP、state BACKUP

Master01、Master02、Master03三个节点中的priority 值分别设置为设置为100、99、98

将10.255.253.88修改为实际使用的vip

2)启动服务

systemctl start keepalived && systemctl enable keepalived && systemctl status keepalived

2、配置haproxy(三台master节点操作)

1)配置haproxy

vim /etc/haproxy/haproxy.cfg

清空内容后将如下内容填写到配置文件

global

#设置日志

log 127.0.0.1 local7 info

#用户与用户组

user root

group root

#守护进程启动

daemon

#最大连接数

maxconn 4000

#默认配置

defaults

log global

mode http

option httplog

option dontlognull

timeout connect 5000

timeout client 50000

timeout server 50000

listen stats

bind 0.0.0.0:1080

stats enable

stats uri /haproxyadmin

stats auth admin:admin

stats admin if TRUE

frontend localnodes

bind *:6444

mode tcp

option tcplog

default_backend kube_apiserver

timeout client 1m

backend kube_apiserver

mode tcp

balance roundrobin

option tcp-check

server server1 10.255.253.40:6443 check port 6443 inter 2000 rise 3 fall 3 weight 30

server server2 10.255.253.41:6443 check port 6443 inter 2000 rise 3 fall 3 weight 30

server server3 10.255.253.42:6443 check port 6443 inter 2000 rise 3 fall 3 weight 30

注意:

将10.255.253.40、10.255.253.41、10.255.253.42修改为实际ip地址

2)启动服务

systemctl enable haproxy && systemctl start haproxy && systemctl status haproxy

3、配置docker(所有节点操作)

1)修改docker 的Cgroup Driver为systemd

修改或创建/etc/docker/daemon.json,加入下面的内容:

{

"exec-opts":["native.cgroupdriver=systemd"]

}

2)启动docker、设置kubelet开机自启(这里先不要开启kubelet服务)

systemctl enable docker&& systemctl start docker && systemctl enable kubelet

五、使用kubeadm部署kubernetes

1、打印kubeadm的配置文件(master01节点操作)

kubeadm config print init-defaults>kubeadm-config.yml

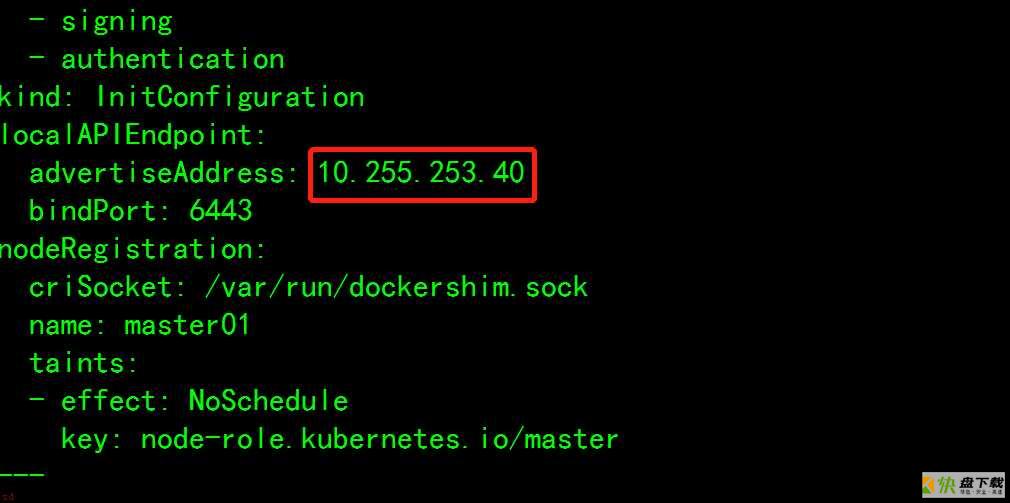

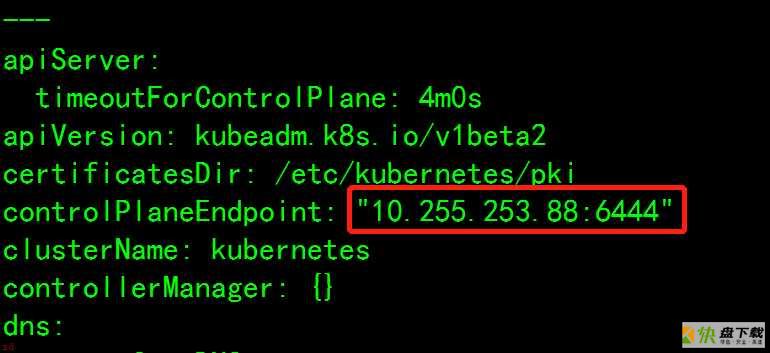

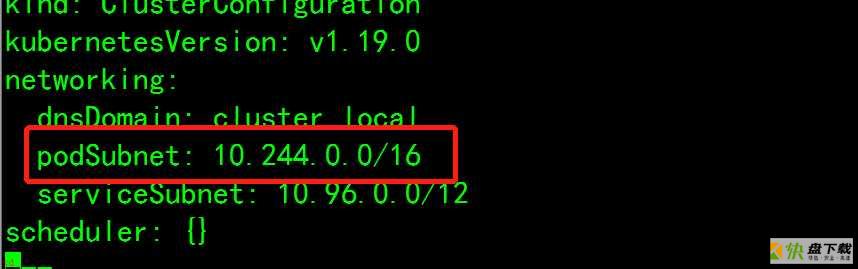

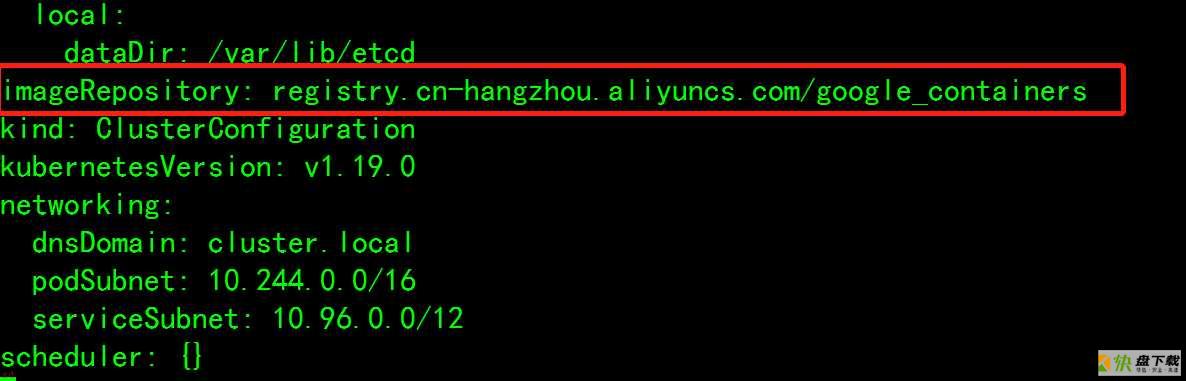

2、编辑kubeadm-config.yml文件(master01节点操作)

vim kubeadm-config.yml

将advertiseAddress选项中的ip地址改为Master01的地址

添加controlPlaneEndpoint配置,其中ip地址为 vip,端口为haproxy映射6443的前端端口6444

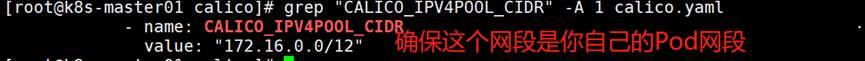

添加podSubnet选项,如果使用flannel网络,则该处为podSubnet: 10.244.0.0/16

将容器镜像仓库改为阿里仓库

imageRepository: registry.cn-hangzhou.aliyuncs.com/Google_containers

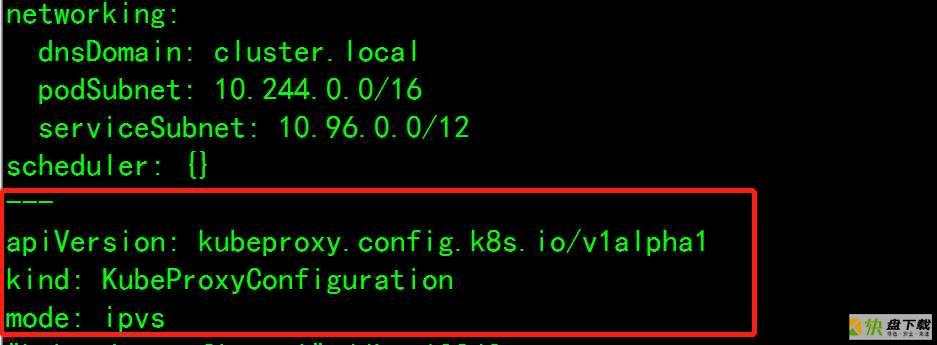

将kubeproxy的mode改为ipvs

添加以下内容

---

apiVersion: kubeproxy.config.k8s.io/v1alpha1

kind: KubeProxyConfiguration

mode: ipvs

3、初始化master01节点

kubeadm init --config=kubeadm-config.yml --upload-certs

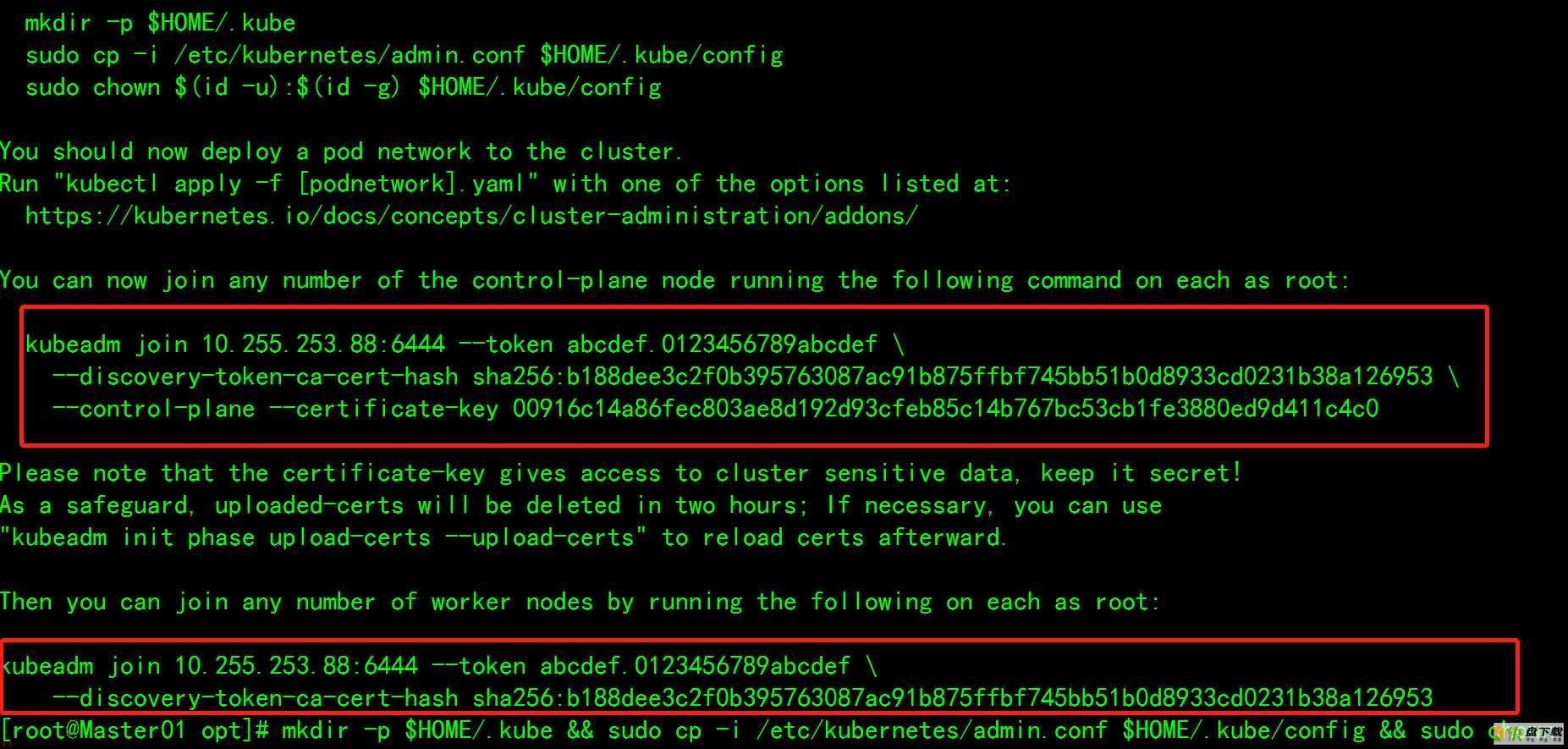

4、等master01节点初始化完成后逐个将Master02、Master03、Node01、Node02加入集群

Master01初始化完成后会出现如下字段、Master02、Master03上执行上面的kubeadm join命令加入集群,Node01、Node02节点使用下面的kubeadm join命令加入集群

5、配置kubctl

mkdir -p $HOME/.kube && sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config && sudo chown $(id -u):$(id -g) $HOME/.kube/config

五、安装flannel网络

1、获取flannel网络的yaml文件

wget https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

2、部署flannel网络

kubectl apply -f kube-flannel.yml

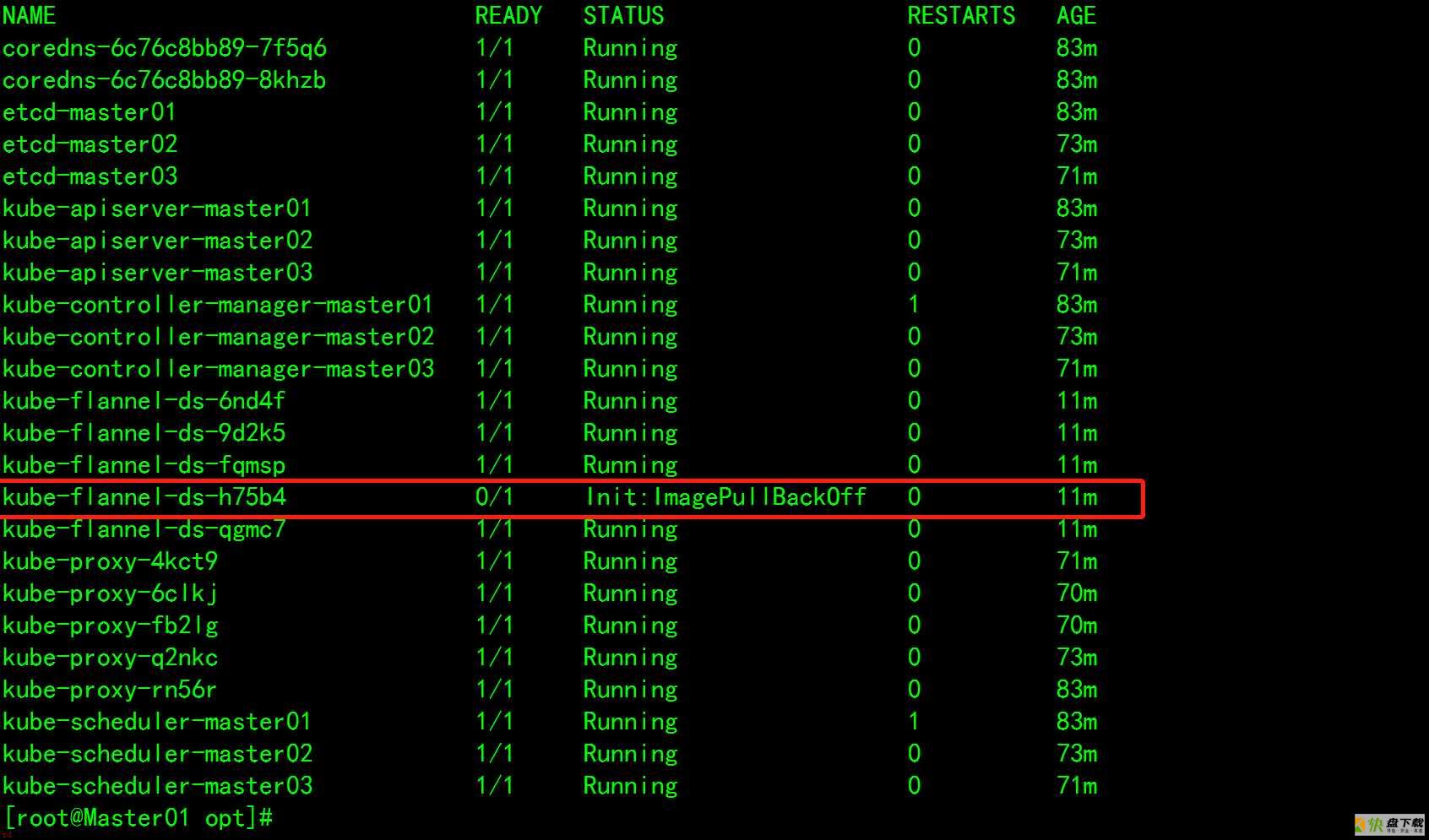

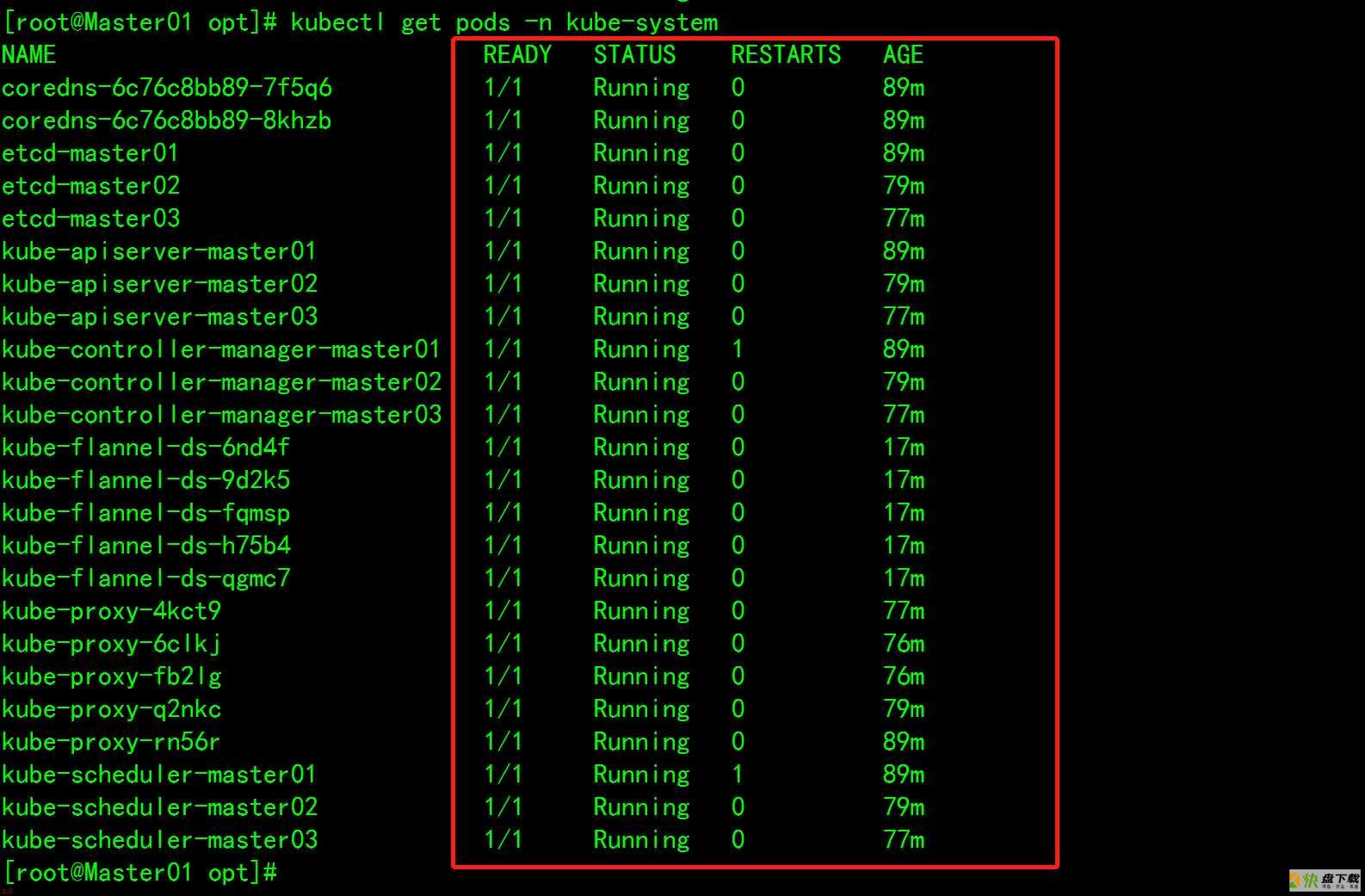

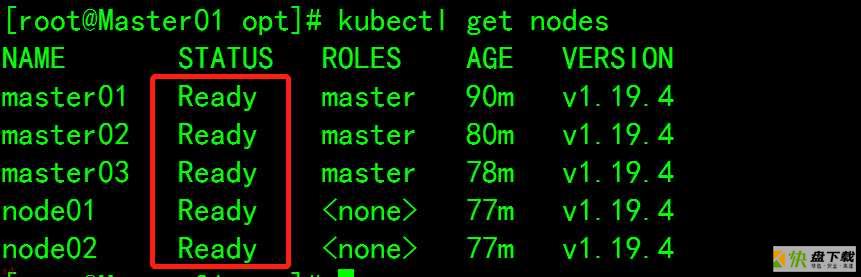

4、等待一段时间后,查看所有pod的状态为Running、所有节点的状态是Ready,则集群正常

kubectl get pods -n kube-system

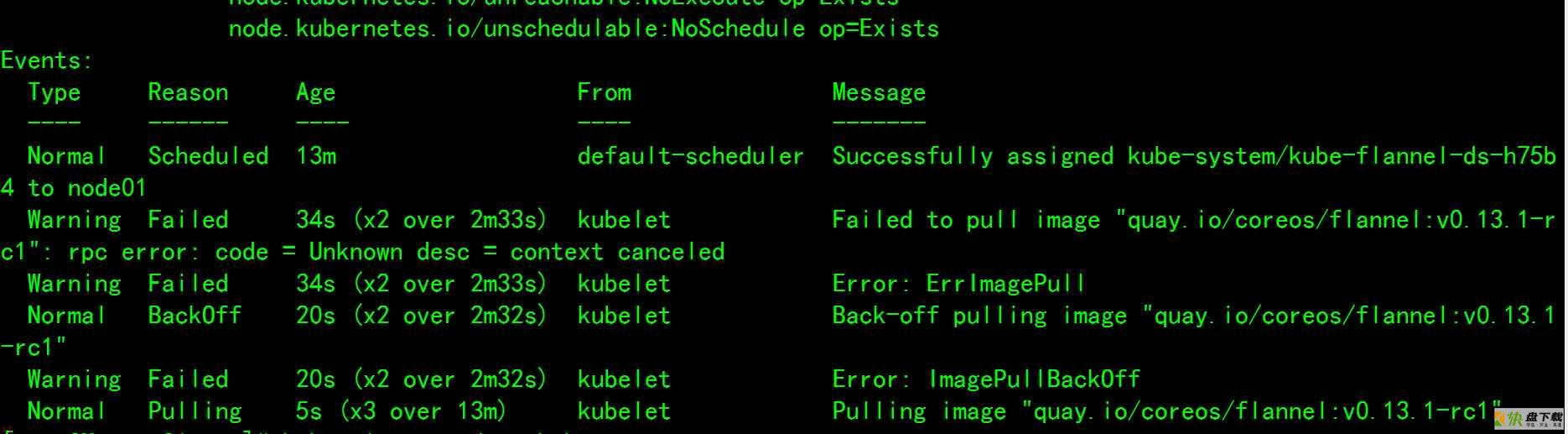

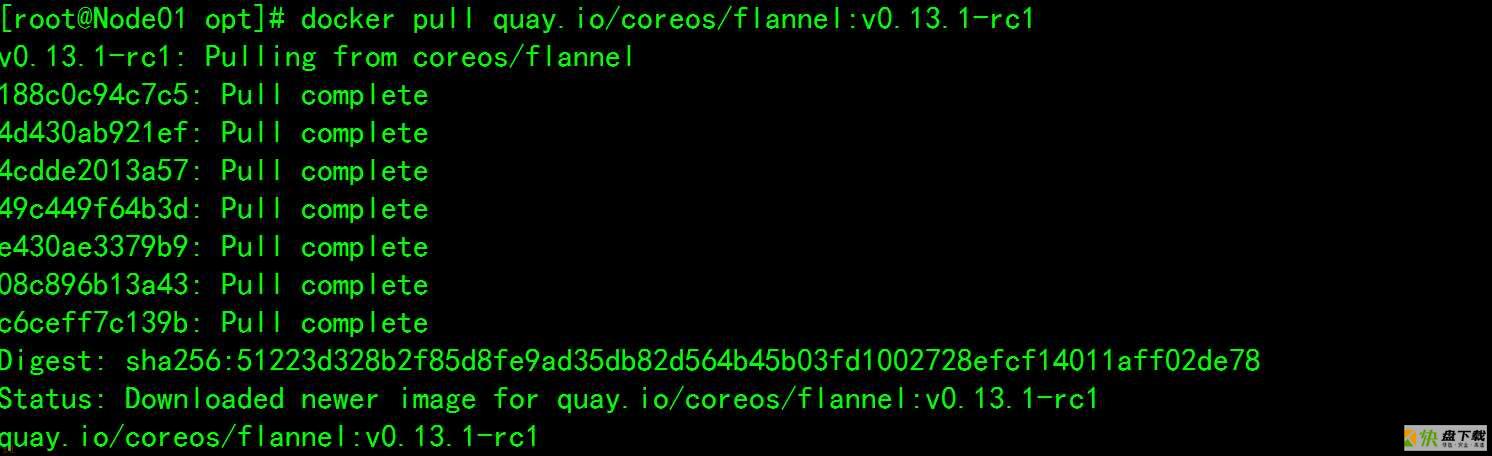

5、镜像拉取失败

查看失败节点信息

kubectl describe pod kube-flannel-ds-h75b4 -n kube-system

进

进

进入Node01手动下载

docker pull quay.io/coreos/flannel:v0.13.1-rc1

kubectl get nodes

至此,高可用架构的Kubernetes集群搭建完成。

基于centos7.9二进制部署kubernetes1.25.4

VMware下centos7安装k8s(Kubernetes)多master集群